El investigador peruano Omar Flórez se prepara para un futuro "muy, muy cercano" en el que las calles estarán llenas de cámaras de vigilancia capaces de reconocer nuestros rostros y recabar información sobre nosotros a medida que caminemos por la ciudad.

PUBLICIDAD

Explica que lo harán sin nuestro permiso, ya que son espacios públicos y la mayoría no solemos taparnos la cara al salir de casa.

Nuestro rostro se convertirá en nuestra contraseña y, cuando entremos a una tienda, esta nos reconocerá e investigará datos como si somos clientes nuevos o asiduos, o en qué lugares hemos estado antes de cruzar la puerta. De toda la información que recabe, dependerá el trato que nos dé esa empresa.

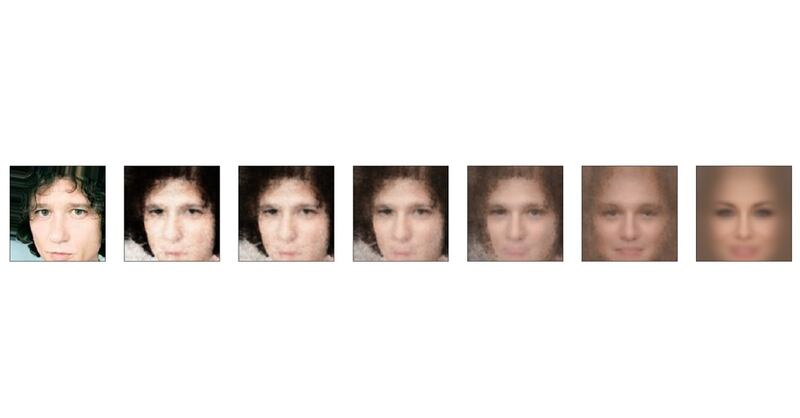

Flórez quiere evitar que aspectos como nuestro género o color de piel formen parte de los criterios que esas compañías evalúen a la hora de decidir si merecemos un descuento u otra atención especial. Algo que puede suceder sin que las mismas firmas se den cuenta.

La inteligencia artificial no es perfecta: incluso si no es programado para hacerlo, el software puede aprender por su cuenta a discriminar.